ChatGPT 何许人也

有时候会想,如果chatGPT是人,它会是一个怎样的人呢?下面是我的推测过程。

首先,她应该是女人

会推测而不会计算

你问它: 3457 * 43216 = ,它回答 149261912 (这是错的。正确结果是 149397712)。

之所以结果的 2 是对的,仅仅因为它读了太多的文字资料以后,隐约感觉到 7 结尾的文字,乘号,6 结尾的文字,和 2 结尾的文字比较「押韵」从语感上比较像一首诗。

所以它就学会了这样的文字,而不是学会了计算。

感性而不理性

有没有觉得,当自己跟老婆吵架时,你讲什么正确的道理都是徒劳,她不在乎对错而在于你有没有顾及她的感受。这印证《男人来自火星,女人来自金星》中说到的一个观点:男人和女人在思维理解上有本质的不同,男人注重理性,女人注重感性。

没错,chatGPT不擅长理性计算,在背诵了一堆堆文字资料后,她觉得”顺口”就认为是对的答案,就是这么任性就是这么感性。

所以,ChatGPT肯定是记忆力超强,天生对数字逻辑一窍不通的女人。

其次,她有工作经验且善解人意

预训练:增加工作经验

举个栗子:家里请阿姨,来你家之前阿姨会接受家政公司的岗前培训,怎么拖地,怎么弄饭,包括怎么带小孩,这样保证了阿姨到雇主家可直接干活。

ChatGPT一开始就知道客观既定的自然规律,比如苹果是水果而不是石头。原因是在被使用之前它经过了岗前培训,也就是GPT中的P(Pre-trained 预训练和微调),保证它可以直接上手就干,而不是磨磨唧唧等你教完它所有之后才会干活。

预训练是给ChatGPT提供基础技能,让其有工作经验,直接上手就干,节约使用者成本。

微调:让她善解人意

举个栗子:还是上面那个阿姨。

上岗后,阿姨的技能和习惯可能跟雇主的不一样,比如雇主要减肥,做饭就不做三菜一汤了,全部变青菜,不要白米饭要西蓝花,OK , 三菜一汤是预训练的标配结果,全部青菜是根据雇主习惯进行的微调。微调让chatGPT更加符合自己口味了。

再比如:如果你要问chatGPT 你公司年假多少?他肯定回答不出来。

但是如果给他录入你公司考勤制度信息之后,它就知道你公司年假多少了。这个过程就是微调。

微调是给模型提供使用者个性化信息,让其与使用者更加同频,给使用者感觉是,它知我,知己也!

再次,她是语言学家

当你用不同语言时,她知道用对应语言你。

当你觉得文字太长,她可以帮你变短。

当你想要她翻译成别的语言,她可以翻译成外语。

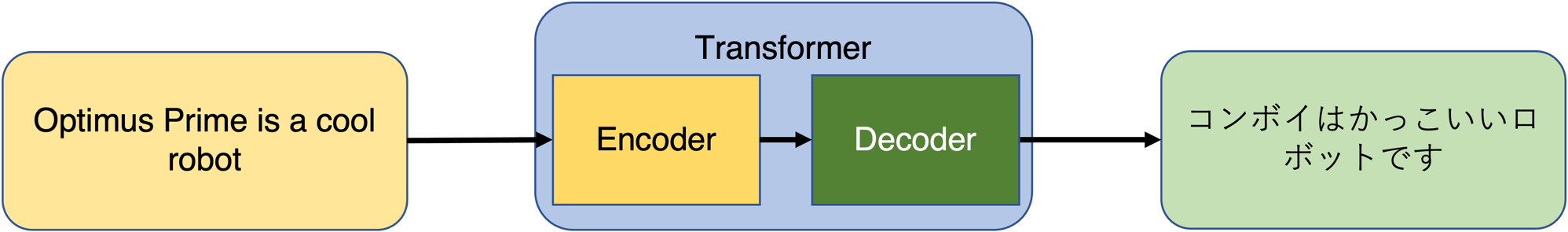

这其中归功于GPT中的T:Transformer转换器。该模块作用类似电源转换器: 220v进12v出

转换器模块工作流程:转换器依据预训练中的经验,将输入转换成向量表示,该向量中包含了上下文,输入含义等信息(类似二维码)。向量可以看做GPT可识别的数据结构,当使用者提出不同需求时,转换器根据该向量变换生成新的输出。

如图中,输入经过Encoder编码成向量,向量根据用户需求Decoder成不同长度,语言的输出。

转换器实现将固定输入转换成各种不同输出的功能。

最后

本文结合生活中的例子推测 ChatGPT 是怎样的人。ChatGPT 中实际过程比这个复杂得多,其过程可能不严谨,但旨在对 ChatGPT 中 G P T 含义进行通俗化解释,希望各位大佬喜欢。

彩蛋

参考链接

Transformers Models in Machine Learning: Self-Attention to the Rescue